Tecnologia para smartphones e tablets dá “visão” a invisuais

Uma recente investigação, financiada pela Google Faculty Research Award, está a desenvolver uma tecnologia móvel adaptável a smartphones e tablets que poderá facilitar a mobilidade de pessoas cegas ou com deficiência visual.

Este método, testado por especialistas da Universidade de Lincoln, no Reino Unido, utiliza uma visão computorizada e equipamentos de aprendizagem que, através de um sistema de visão inteligente inserido num equipamento móvel, possibilita que pessoas que sofram destes problemas tenham maior autonomia.

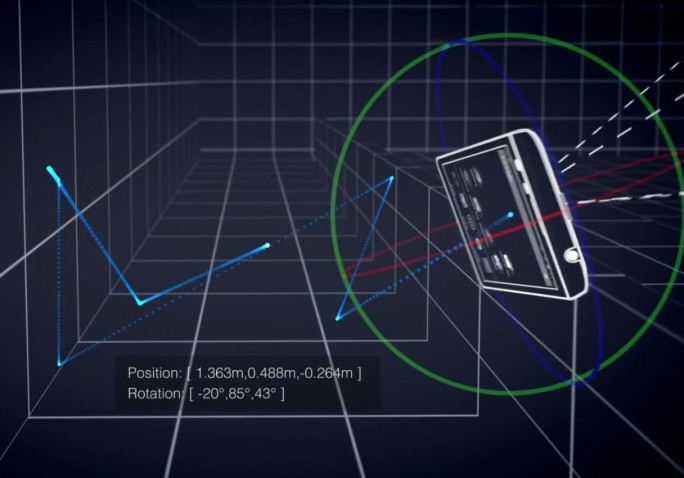

A equipa de investigadores, que baseia o seu estudo em tecnologias de assistência desenvolvidas no Centro para Sistemas Autónomos de Lincoln, pretende utilizar cores e sensores de profundidade, introduzindo-os em smartphones e tablets. Esta tecnologia é semelhante ao projeto Tango da Google que apresenta um mapa da área apontada por meio de um sistema tridimensional e geográfico que reconhece objetos. Posteriormente, os peritos pensam desenvolver uma interface que interligue a informação obtida pelo aparelho ao utilizador do mesmo, utilizando, para tal, vibrações, sinais sonoros ou um sintetizador de voz que formule palavras.

Segundo Nicola Belloto, especialista em perceção mecânica e robótica centrada no homem, da Escola de Ciências da Computação de Lincoln, o desenvolvimento desta tecnologia excluirá a utilização de outros recursos visuais, tais como os cães-guias e câmaras ou sensores dos wearables.

Ainda que, atualmente, existam aplicações capazes de reconhecer objetos e que convertam em voz o local geográfico em que o equipamento se encontra, o potencial destes sensores não tem sido aproveitado na sua totalidade, daí que se tenha pensado nesta alternativa.

A criação deste sistema incorpora um conjunto de tecnologias já existentes, que inseridas num só dispositivo contribuem para um maior autonomia da pessoa que as utiliza e que são de fácil usabilidade.

O estudo conta com o apoio da Google, sendo que colaborará com especialistas da mesma no projeto Active Vision with Human-in-the-Loop for the Visually Impaired.